Le 9 septembre CHINA SCIENCE publiait l'information suivante (traduite de l'anglais) :

Rompant avec des modèles comme ChatGPT, des chercheurs chinois ont développé un nouveau système d'IA, « SpikingBrain-1.0 », qui imite les neurones du cerveau et permet un entraînement très efficace sur des volumes de données extrêmement faibles, ouvrant ainsi une nouvelle voie pour l'informatique et le matériel économes en énergie de nouvelle génération.

Entièrement formé et déduit sur des calculs GPU développés en interne, le modèle à grande échelle atteint des performances comparables à celles de plusieurs modèles open source basés sur l'architecture Transformer sur les défis de compréhension du langage et de raisonnement avec seulement environ 2 % des données de pré-formation requises par les grands modèles traditionnels.Sa capacité à gérer des séquences ultra-longues offre des gains d'efficacité évidents pour des tâches telles que l'analyse de documents juridiques ou médicaux, les expériences de physique des particules à haute énergie et la modélisation de séquences d'ADN.L'équipe de recherche a rendu le modèle SpikingBrain open source et lancé une page de test publique, tout en publiant un rapport technique bilingue à grande échelle, validé par l'industrie.

Alors qu'est ce que cette nouvelle solution ?

Le nom est issu de Spiking Neural Networks ou SNN (réseaux de neurones à impulsions), un type de réseau de neurones artificiels qui simule encore plus fidèlement le fonctionnement du cerveau humain .

C'est donc sa principale différence avec les autres LLM tous basés sur l'architecture traditionnelle "TRANSFORMER" : il utilise des "neurones à impulsions". Ces impulsions ne sont donc émises que lorsque le potentiel membranaire (la différence de tension électrique entre l'intérieur et l'extérieur d'une cellule, mesurée à travers sa membrane cellulaire) du neurone dépasse un certain seuil.

Ce qui est annoncé :

- SpikingBrain a géré un prompt de 4 millions de tokens 100× plus vite qu’un Transformer classique

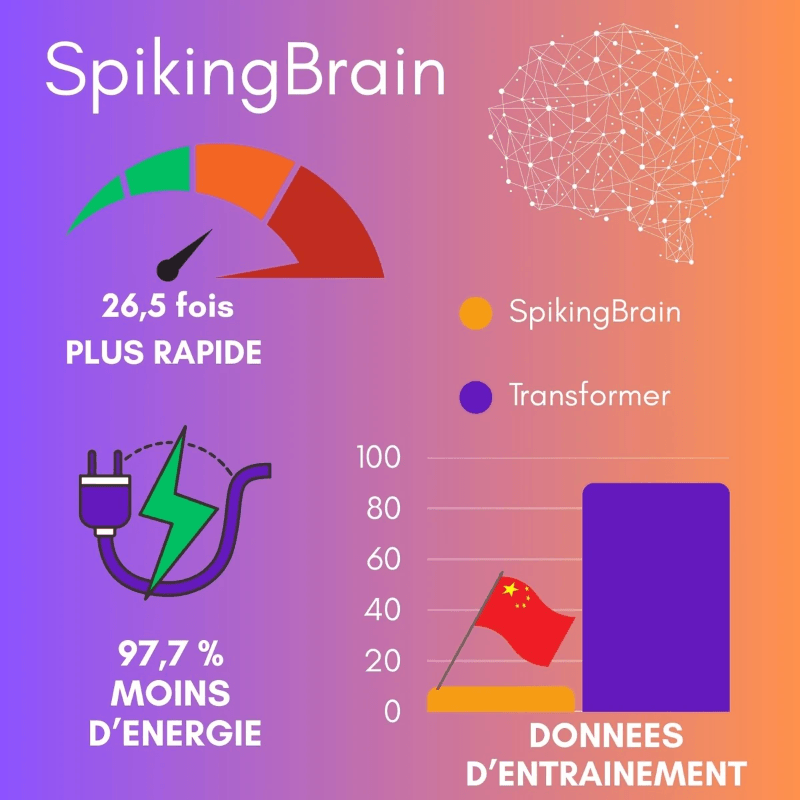

- Sur un contexte d’1 million de tokens, il a généré le premier mot 26,5 fois plus vite. Et tout ça en maintenant près de 70 % de neurones inactifs, une économie d’énergie "by design" évidente. Le modèle consommerait jusqu'à 97,7 % moins d'énergie que les approches traditionnelles

- L'entrainement s’est fait sur 150 milliards de tokens seulement, soit à peine 2 % des volumes requis par les LLM actuels !

- SpikingBrain tourne sur les puces MetaX C550 fabriquées en Chine afin de ne pas être dépendanst de Nvidia.

- Accessibilité : Une version de 7 milliards de paramètres du modèle a été rendue open-source, et une version plus grande de 76 milliards de paramètres est disponible pour des tests publics.

Les cas d'usages envisagés

- l’analyse de documents juridiques et médicaux volumineux,

- la recherche en physique énergétique,

- le décodage du génome et de ses milliards de données.

Ou en est-il ?

- SpikingBrain 1.0 n'a pas encore passé le processus d'évaluation par les pairs ("peer-review")

- Aucun score officiel n'a été publié sur les benchmarks académiques standard comme GLUE ou MMLU.

- L'article arvix ici SpikingBrain Technical Report: Spiking Brain-inspired Large Models

- SpikingBrain a été développé par une équipe de recherche de l'Institut d'Automatisation de l'Académie chinoise des sciences (Chinese Academy of Sciences) à Pékin

- Le projet est hébergé sur GitHub sous GitHub - BICLab/SpikingBrain-7B

- Les directeurs principaux du projet sont :

- Li Guoqi (correspondant principal : guoqi.li@ia.ac.cn)

- Xu Bo (correspondant principal : xubo@ia.ac.cn)